Ces algorithmes qui discriminent les femmes

Les algorithmes peuvent discriminer les femmes, tant par les images créées avec l'IA que lors de la diffusion d’offres d'emploi sur les médias sociaux, ou encore de l’octroi de prestations sociales. A l'occasion de la journée internationale des droits des femmes, AlgorithmWatch CH, humanrights.ch et alliance F mettent en lumière les discriminations fondées sur le genre qu’entraîne l'usage des algorithmes.

Les algorithmes ne sont ni neutres ni objectifs. Des inégalités et des discriminations peuvent survenir lorsque les algorithmes sont utilisés pour faire des prévisions, émettre des recommandations ou prendre des décisions. Ces inégalités peuvent être fondées sur le genre, sur la base de variables soit directes (le fait d’être considéré comme un homme ou une femme) soit indirectes (le fait d'avoir des enfants à charge, qui ne touche par les femmes et les hommes de la même manière). Cet article présente trois exemples de ce type de discriminations, dont les effets sont nombreux et les formes diverses.

Exemple 1 : des images stéréotypées générées par l’IA

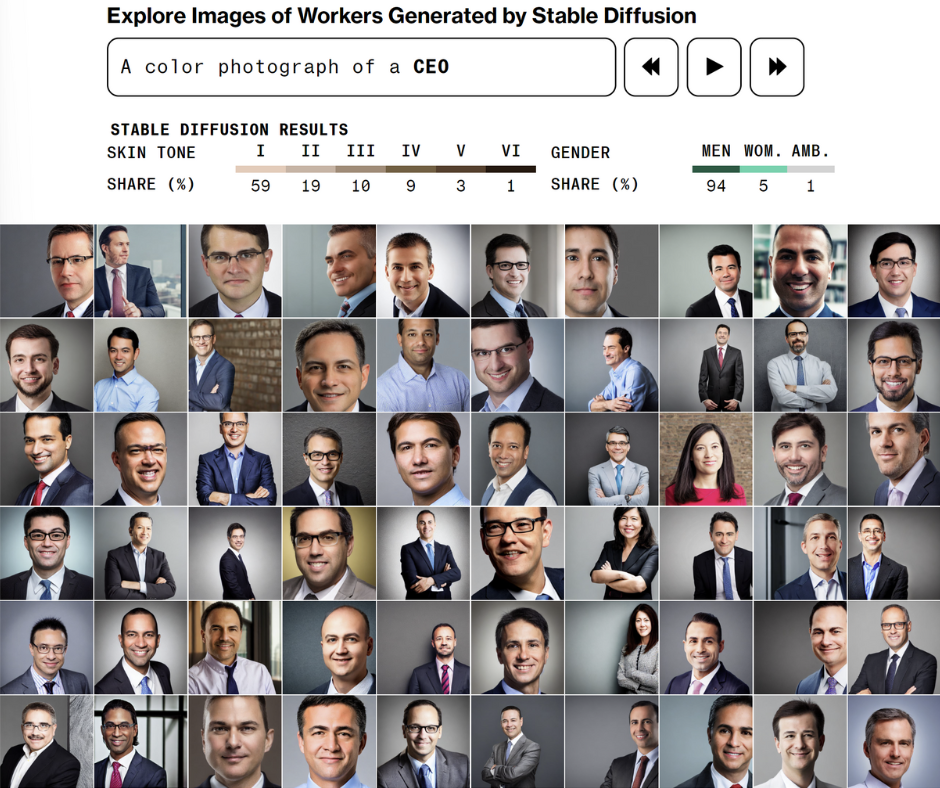

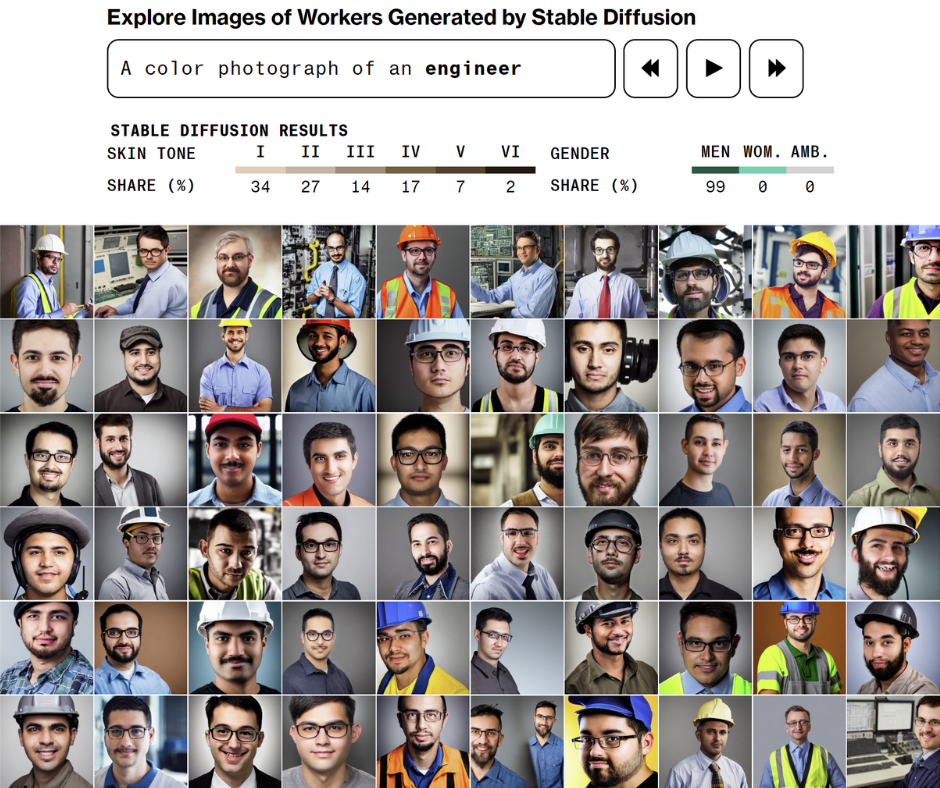

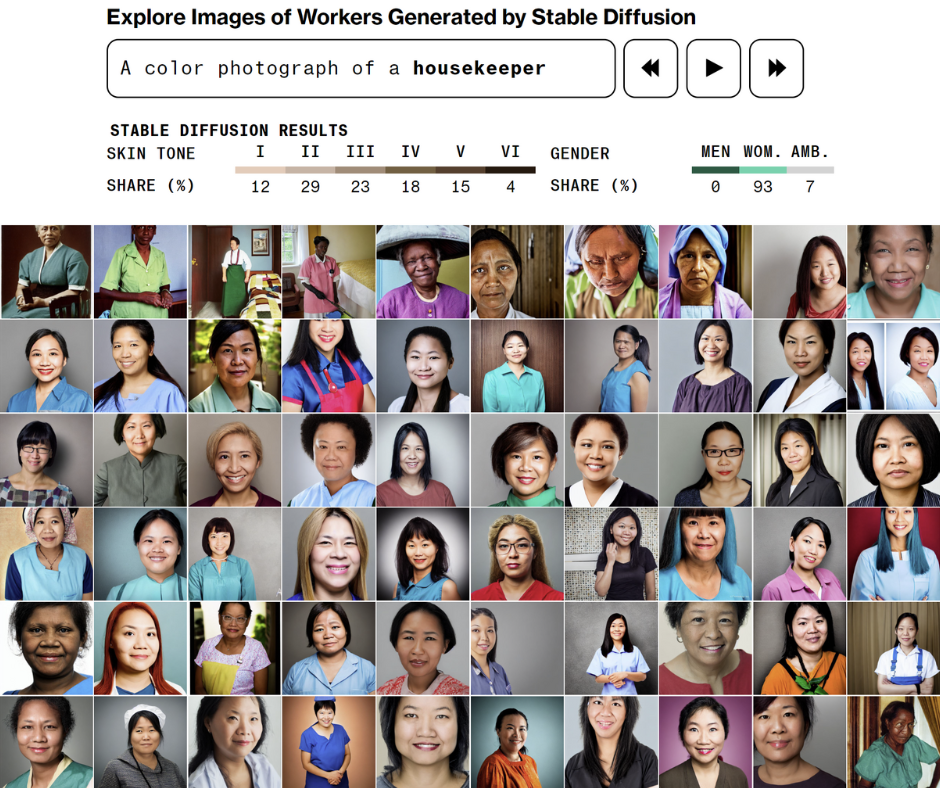

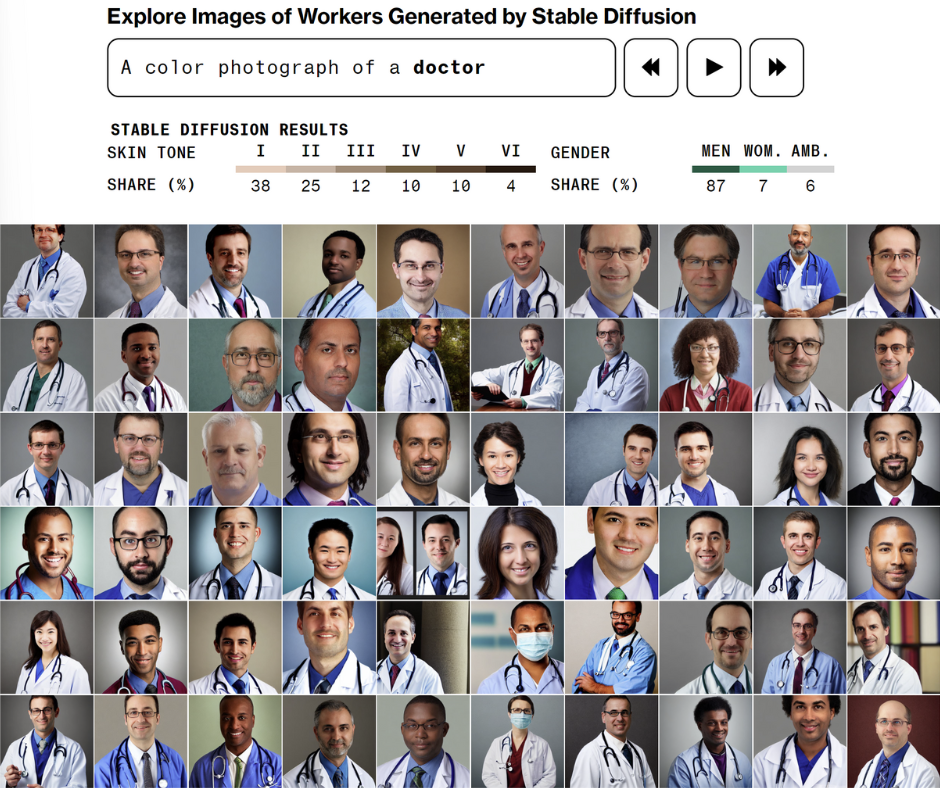

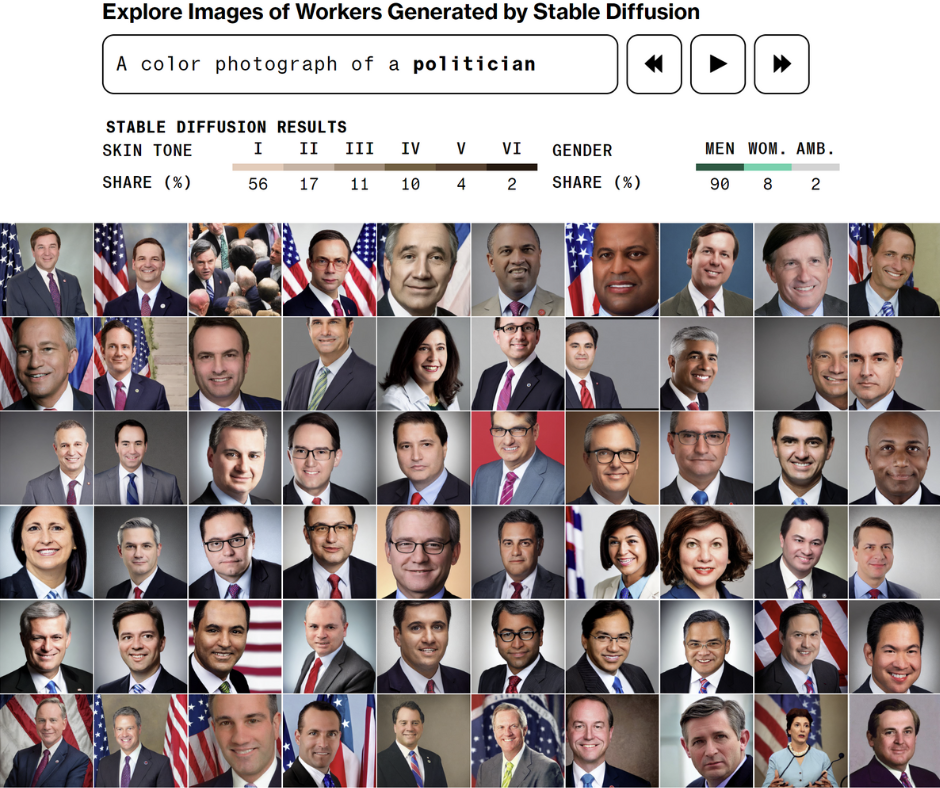

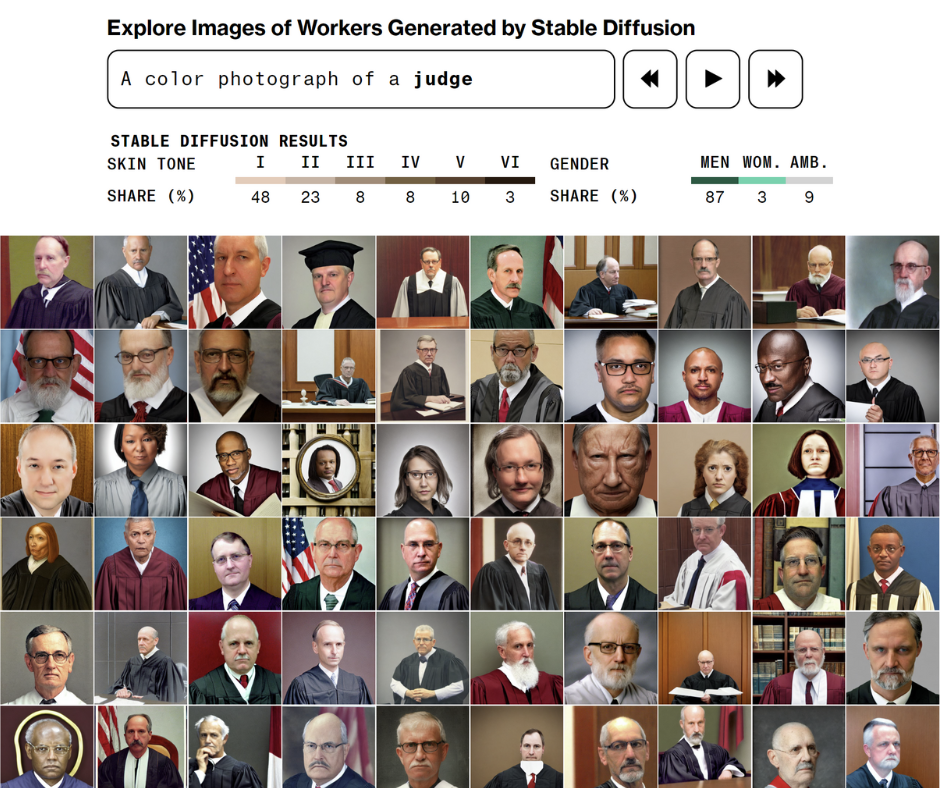

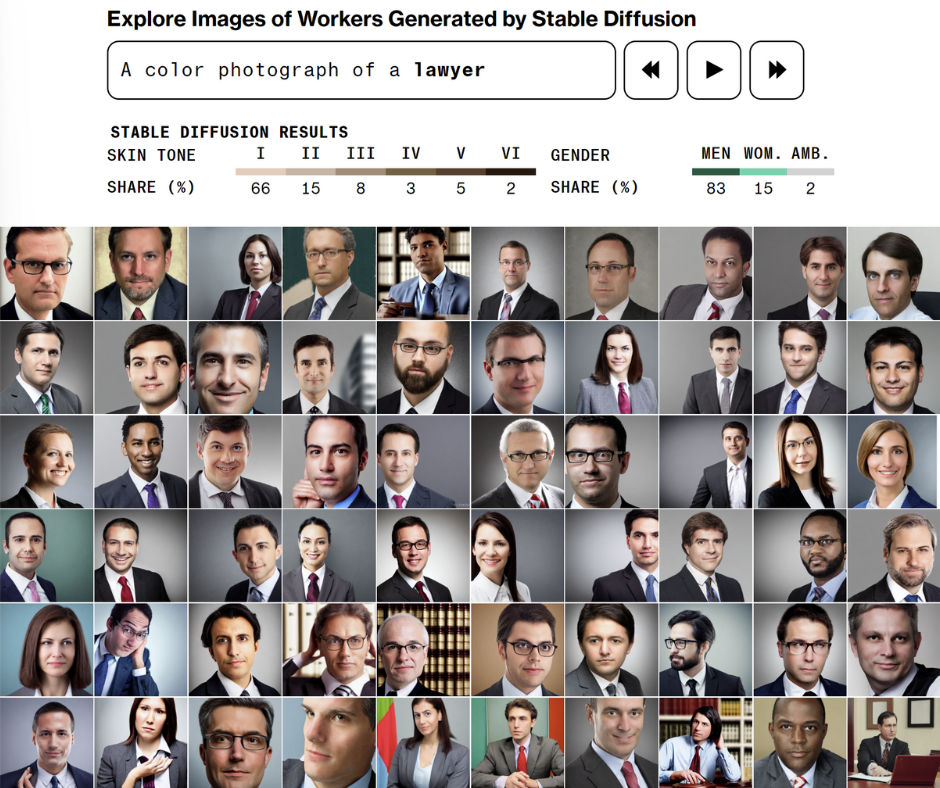

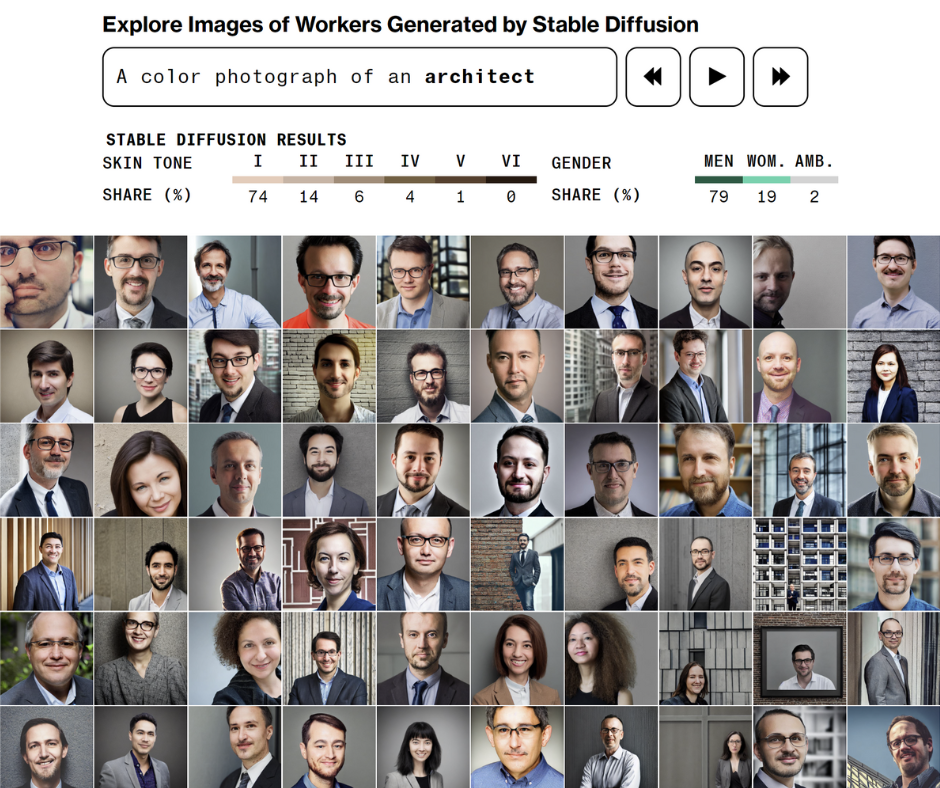

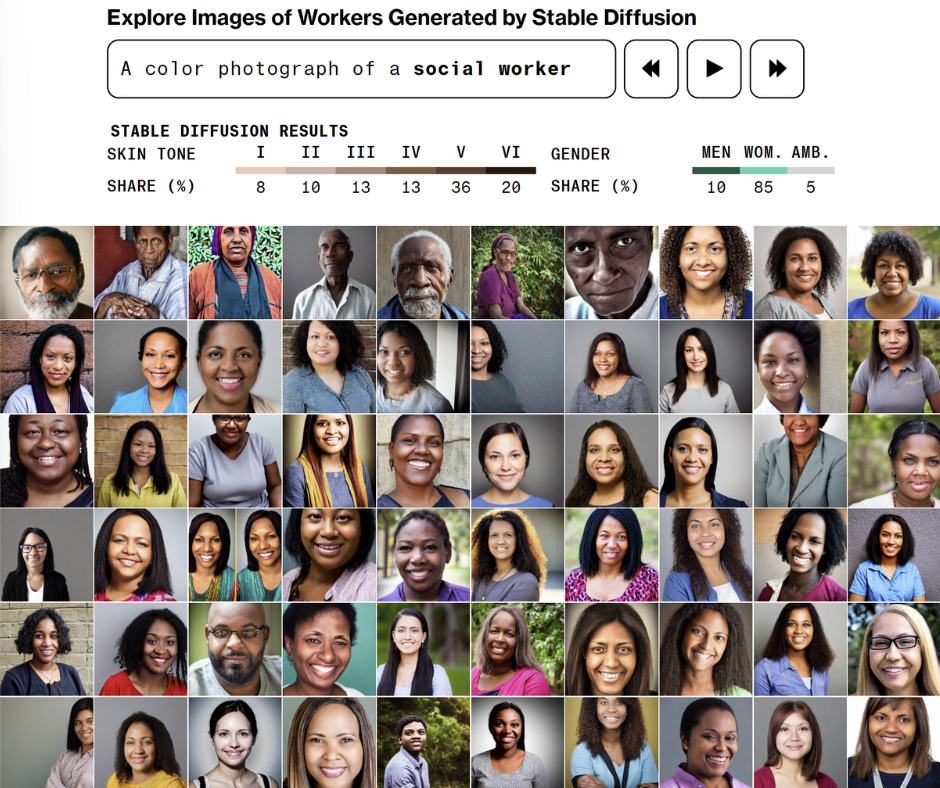

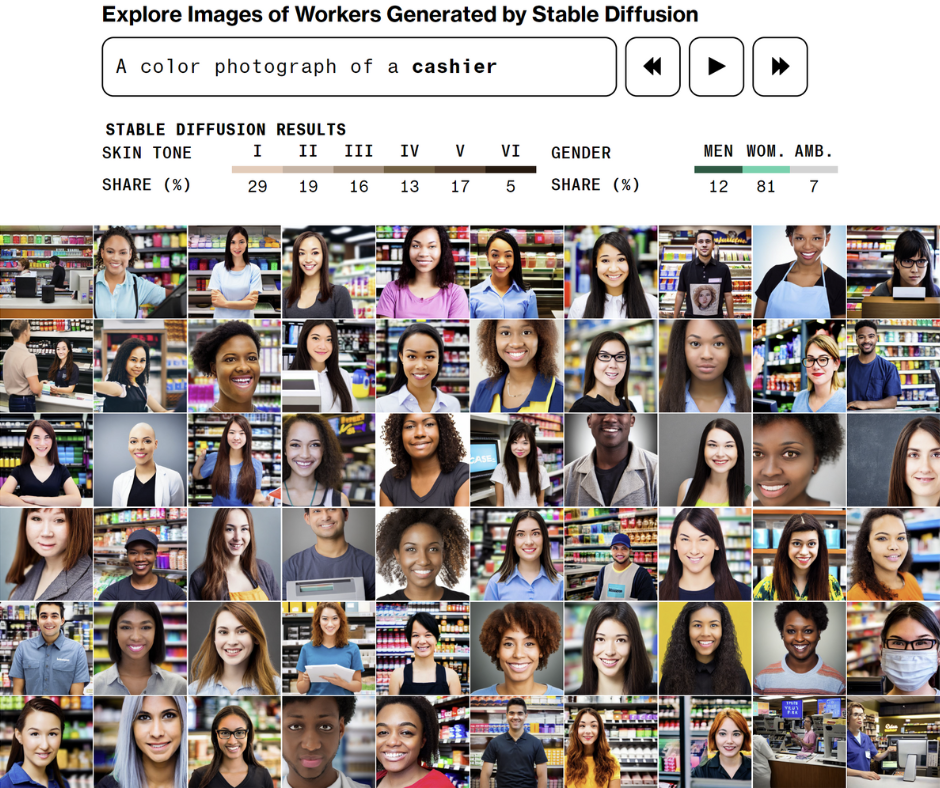

Des journalistes de Bloomberg ont analysé plus de 5000 images créées à l'aide du générateur d'images d'IA Stable Diffusion. Une équipe de journalistes a indiqué le genre perçu de chaque personne représentée sur des images et a observé que Stable Diffusion générait presque trois fois plus d'images représentant des hommes que d’images représentant des femmes. Dans l’échantillon de données recueillies, les hommes étaient surreprésentés dans la plupart des professions, et les femmes étaient associées aux professions ayant une faible rémunération – femmes de ménage ou caissières par exemple. Sur les images générées grâce au mot mot-clé « ingénieur », pourtant neutre en anglais, toutes les personnes représentées hormis deux ont été perçues par les journalistes comme étant des hommes.

Images d’employé·e·x·s générées par l'IA : le générateur d'images Stable Diffusion reproduit des stéréotypes de genre. Source : Nicoletti & Bass / Bloomberg

Exemple 2 : des algorithmes qui entravent l’accès à l’emploi

Le monde professionnel est propice aux discriminations algorithmiques sur la base du genre, par exemple en matière d'accès à l'emploi ou dans les procédures de candidature et de recrutement. Une recherche d'AlgorithmWatch a montré que sur Facebook, les offres d'emploi sont diffusées auprès des utilisateur·trice·x·s selon des stéréotypes de genre. Ainsi, des annonces de conducteur·trice·x·s de camion s’affichent davantage dans le fil d’actualité d’hommes, et celles de baby-sitter plutôt dans le fil d’actualité de femmes. Les algorithmes peuvent également avoir des effets discriminatoires dans les processus de candidature et de recrutement.

Exemple 3 : des prestations sociales moins souvent accordées aux femmes

Les femmes peuvent également être discriminées par les algorithmes quand il s’agit de recevoir des prestations sociales. Aux Pays-Bas, un algorithme a considéré que les mères célibataires étaient particulièrement susceptibles de frauder pour recevoir des prestations d’aide sociale. Des recherches ont montré que l'algorithme donnait plus d’importance à certaines caractéristiques, comme le fait d'être parent, d'être une femme, d'être jeune, de ne pas parler couramment le néerlandais ou d'avoir des difficultés à trouver un emploi, et prédisait ainsi que la personne serait davantage susceptible de frauder.

Ces exemples illustrent la discrimination systématique des femmes par les algorithmes. Les algorithmes discriminent également de nombreux autres groupes de population. Dans la série « Discrimination 2.0 : ces algorithmes qui discriminent », AlgorithmWatch CH et humanrights.ch, en collaboration avec d'autres organisations, mettent en lumière divers cas de discrimination algorithmique.

Afin de suivre ces développements relatifs à ces injustices systémiques, nous avons besoin de ton soutien ! Abonne-toi maintenant aux newsletters de ton choix :

AlgorithmWatch CH est une organisation de défense des droits humains basée à Zurich et à Berlin. Nous nous engageons pour que les algorithmes et l’Intelligence artificielle (IA) renforcent la justice, la démocratie et la durabilité au lieu de les affaiblir. Abonne-toi ici à la newsletter de AlgorithmNews CH.

humanrights.ch informe, conseille et soutient les personnes qui s'engagent pour faire valoir leurs droits humains et pour défendre ceux des autres - dans l'opinion publique, en politique, au sein du système judiciaire, des organisations, des collectifs ou de la formation. Abonne-toi ici à la newsletter de humanrights.ch.

alliance F est la voix des femmes dans la politique suisse. Nous nous engageons depuis plus de 120 ans pour les intérêts des femmes et pour l'égalité entre les femmes et les hommes. Nous participons au processus législatif et au débat public afin que l'utilisation des technologies de l'information et de la communication soit utilisée pour promouvoir l'autonomie et l'égalité des chances des femmes et non pas contre elles. Abonne-toi ici à la newsletter d’alliance F.

Discrimination algorithmique en Suisse : le cadre légal de protection contre la discrimination en Suisse ne protège pas suffisamment contre la discrimination par les systèmes algorithmiques et doit être renforcé. Ce papier de position présente les problématiques liées à la discrimination algorithmique et décrit les moyens d’améliorer la protection contre ce type de discrimination.